A Observabilidade de Dados é importante porque as consequências do tempo de inatividade dos dados podem ser graves.

Leia todos os tópicos:

- A Observabilidade de Dados é Essencial para o DataOps

- Por que a Observabilidade de Dados é Importante?

- Os Principais Recursos das Ferramentas de Observabilidade de Dados

- Observabilidade de Dados versus Testes de Dados

- Observabilidade de Dados versus Monitoramento de Pipeline de Dados

- Observabilidade de Dados versus Qualidade dos Dados

- Observabilidade de Dados versus Engenharia de Confiabilidade de Dados

- Qualidade dos Dados versus Confiabilidade dos Dados

- Sinais de que VOCÊ precisa de uma Plataforma de Observabilidade de Dados

- O Futuro da Observabilidade de Dados

Para engenheiros e desenvolvedores de dados, a Observabilidade de Dados é importante porque o tempo de inatividade dos dados significa desperdício de tempo e recursos; para os consumidores de dados, isso prejudica a confiança na sua tomada de decisão.

Nesse sentido, o valor do monitoramento do pipeline de dados e da Observabilidade de Dados é quase inestimável. Dito isto, é improvável que o diretor financeiro aceite “inestimável” quando você estiver construindo seu caso de negócios. Então, vamos dar uma olhada em como as equipes de dados mediram a qualidade dos dados.

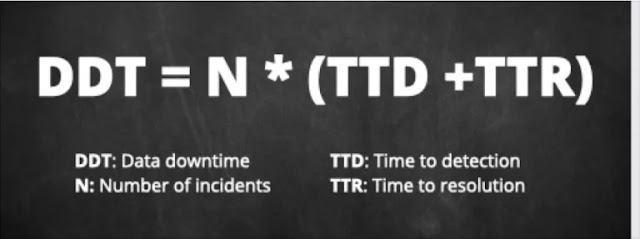

Um cálculo simples para o número estimado de incidentes que você tem a cada ano (tenha você os detectando ou não) pode ser feito dividindo o número de tabelas que você tem em seu ambiente por 15.

Você pode então multiplicar esse número pelo tempo médio de detecção e pelo tempo médio de resolução. Se você ainda não está capturando essas métricas, não se preocupe, você não está sozinho.

Nossa pesquisa do setor revelou que a média do setor é de cerca de 4 horas e 9 horas, respectivamente. Sinta-se à vontade para usar ou ajustar essas estimativas com base na maturidade da qualidade dos dados da sua organização.

Parabéns, você acabou de calcular o tempo de inatividade de seus dados! Agora vamos calcular seu custo e, portanto, o valor de uma solução de observabilidade de dados.

A primeira parte do cálculo, custo da mão-de-obra, é relativamente simples. Como sabemos que os profissionais de qualidade de dados gastam cerca de 40% do seu tempo em práticas ineficientes de qualidade de dados, podemos usar esta fórmula:

Total de engenheiros de dados x 1.804 (horas médias de trabalho em um ano) x US$ 62 (salário médio) x 0,4

O custo operacional da má qualidade dos dados é um pouco mais difícil de quantificar. Um incidente de dados pode ser tão inofensivo quanto um painel quebrado que ninguém usa ou tão doloroso quanto relatar números incorretos a Wall Street.

Uma maneira de estimar isso é medir o risco geral. Se uma organização investe em sua equipe de dados para aumentar a eficiência geral em 10% (ou insira seu próprio valor aqui), então, para cada hora de inatividade de dados, podemos assumir que a produtividade da organização foi reduzida em 10%. A fórmula é então:

Tempo geral de inatividade de dados x% de redução na receita horária gerada.

Clique aqui e nos contate via What's App para avaliarmos seus projetos

Comente e compartilhe este artigo!

Leia também:

Nenhum comentário:

Postar um comentário